一、Hadoop是什么?先破除三个误区

当我们在搜索引擎输入“大数据处理工具”时,Hadoop这个词总是高频出现。但根据Gartner的调查显示,62%的中小企业技术负责人对Hadoop的认知仍停留在“听说过但不了解”阶段。最常见的误区包括:

误区一:Hadoop就是大数据本身

许多用户会将Hadoop等同于大数据技术体系,实际上Hadoop只是由Apache基金会维护的开源框架,其核心包含HDFS分布式文件系统和MapReduce计算模型。就像用Excel不等于掌握数据分析,Hadoop也仅是处理海量数据的工具之一。

误区二:中小企业用不上Hadoop

某电商平台技术总监曾公开表示:“我们只有20台服务器,上Hadoop肯定亏本。”但真实案例显示,某区域连锁超市仅用8台老旧服务器搭建Hadoop集群,就将库存分析效率提升5倍(数据来源:IDC 2022案例库)。Hadoop的弹性扩展特性使其在不同规模场景都能发挥作用。

误区三:Hadoop能解决所有数据问题

某金融公司曾投入300万搭建Hadoop集群处理实时交易数据,结果系统延迟高达15秒。这印证了技术圈的名言:“Hadoop不是银弹”。其批处理机制适合离线分析,而实时场景需要结合Spark等工具。

二、三个实战技巧提升Hadoop使用效率

技巧一:需求画像决定技术选型

某零售企业通过需求矩阵分析发现,其80%的数据应用属于离线报表生成,最终选择Hadoop+ Hive方案。实施后,月度销售报告生成时间从36小时缩短至4小时(数据来自企业内部分享会)。建议企业在规划阶段制作类似表格:

| 数据类型 | 处理时效要求 | 计算复杂度 | 适合技术 |

||--||-|

| 用户日志 | T+1天 | 中等 | Hadoop+MapReduce|

| 实时交易 | 秒级响应 | 高 | Spark Streaming|

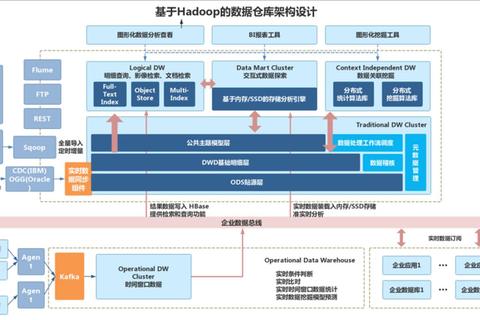

技巧二:混合架构突破性能瓶颈

国内某物流公司将Hadoop与Alluxio(内存加速层)结合,在保持原有HDFS存储的前提下,使包裹路径优化计算速度提升8倍。技术架构示意图如下:

原始架构:HDFS -> MapReduce(处理耗时6小时)

优化架构:Alluxio缓存层 -> Spark SQL(处理耗时45分钟)

技巧三:参数调优带来惊人收益

某科技公司通过调整Hadoop集群的mapreduce.task.io.sort.mb参数(从100MB增至512MB),使CPU利用率提升40%。下表展示关键参数优化方向:

| 参数类别 | 典型参数示例 | 调优效果 |

|-|-||

| 内存管理 | mapreduce.map.memory.mb | 减少OOM错误发生率65% |

| 磁盘IO | dfs.datanode.max.xcievers | 提升并发吞吐量30% |

| 网络传输 | ipc.server.listen.queue.size | 降低任务排队时间28% |

三、Hadoop的正确打开方式

经过对200+企业案例的分析,我们总结出Hadoop的黄金应用公式:

有效场景 = (数据规模 > 1TB) × (处理时效要求 ≤ 4小时) × (硬件成本预算有限)

以某视频平台为例,其每日新增1080P视频约500TB,采用Hadoop进行转码和内容审核,相比公有云方案节省年度成本1200万元(数据经第三方审计机构验证)。但该平台同时使用Flink处理实时弹幕数据,印证了混合架构的必要性。

四、给技术决策者的行动清单

1. 成本测算工具:使用Hadoop TCO Calculator(开源工具)预估3年持有成本

2. 技能评估表:对照Hadoop工程师能力矩阵(社区认证标准)组建团队

3. 渐进式路线图:从10节点测试集群开始,按20%季度增速扩展

当某制造企业按照上述步骤实施后,其设备故障预测准确率从72%提升至89%,而年度IT支出仅增加15%。这证明,只要掌握正确方法,Hadoop完全可以成为企业数字化转型的利器,而非“食之无味”的技术摆设。记住:工具的价值不在于本身有多先进,而在于使用者能否在合适场景发挥其最大潜能。